ربات

های وب (که به نام های سرگردانان وب، خزندگان یا عنکبوت ها نیز شناخته می

شوند) به برنامه هایی می گویند که به صورت خودکار سراسر وب را می گردند و

جستجو Ù…ÛŒ کنند. موتورهای جستجویی نظیر Ú¯ÙˆÚ¯Ù„ از آنها برای Ù…Øتوای درون وب

استÙاده Ù…ÛŒ کنند Ùˆ اسپمرها برای به دست آوردن ایمیل آدرس ها. آنها کارایی

های بی شماری دارد.

توضیØات ÙˆØ§Ø¶Ø Ø¯Ø± مورد Ùایل robots.txt

دارندگان سایت ها از robots.txt جهت معرÙÛŒ ساختار سایتشان به ربات های سراسر وب استÙاده Ù…ÛŒ کنند.

یک مثال در ارتباط با چگونگی کارکرد این Ùایل: یک ربات جستجوگر مثل ربات

Ú¯ÙˆÚ¯Ù„ قصد ورود به سایت شما را دارد تا موارد مورد نظرش چون خطاها، صÙØات،

Ù…Øتوا، تصاویر Ùˆ غیره را ایندکس کند. در صورتی Ú©Ù‡ صÙØÙ‡ ورودی شما

http://www.example.com/welcome.html باشد، ربات مورد نظر ابتدا و پیش از

هر نوع بررسی سایت شما نشانی http://www.example.com/robots.txt را چک

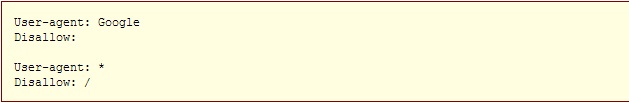

خواهد کرد. و در نهایت به این دستورات بر خواهد خورد:

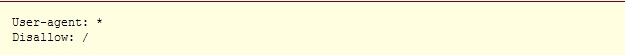

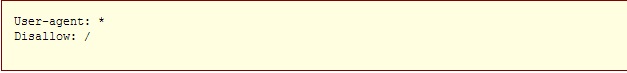

عبارت User-agent: * به معنای این است که این سایت و این دستور برای هم?

ربات ها یکسان است. Ùˆ قسمت Disallow: / Øاوی این پیام است Ú©Ù‡ هیچ رباتی

نباید هیچ قسمتی از این سایت را بررسی و مشاهده نماید.

دو نوع نگرش نسبت به استÙاده کنندگان از robots.txt وجود دارد:

1. ربات ها می توانند robots.txt شما را نادیده بگیرند! به خصوص

آنکه ربات های مخرب، کارشان اسکن نمودن سراسر وب برای یاÙتن نقص های

امنیتی، ایمیل آدرس ها Ùˆ غیره است، کوچکترین توجهی به Ù…Øتویات robots.txt

ندارند.

2. Ùایل robots.txt یک Ùایل در دسترس عموم Ù…ÛŒ باشد. هرکسی Ù…ÛŒ

تواند ببیند که شما کدام قسمت را تمایل ندارید که ربات های دیگر ببینند.

*پس برای مخÙÛŒ نمودن اطلاعاتتان با استÙاده از robots.txt تلاش نکنید.

Ù†ØÙˆ? ساخت یک Ùایل robots.txt

کجا آن را قرار دهیم؟

پاسخ کوتاه: در بالاترین Ø³Ø·Ø Ø¯Ø§ÛŒØ±Ú©ØªÙˆØ±ÛŒ سرور سایتتان

پاسخ کامل: زمانیکه یک روبات به دنبال Ùایل robots.txt برای نشانی URL

شما می گردد، به دنبال اولین اسلش پس از اکستنشن شما می رود و به صورت

اتوماتیک عبارت robots.txt را قرار می دهد.

برای مثال اگر داشته باشیم: http://www.example.com/shop/index.html،

ربات مورد نظر /shop/index.html را Øذ٠نموده Ùˆ /robots.txt را جایگزین Ùˆ

در انتهای URL قرار می دهد.

به همین خاطر شما به عنوان دارنده سایت Ù…ÛŒ بایست این Ùایل را در مکان

صØÛŒØ Ùˆ جایی قرار دهید Ú©Ù‡ در نتایج جستجو دیده شده Ùˆ عمل نماید. معمولا این

Ùایل را در جایی مشابه همان صÙØÙ‡ اصلی سایت (index.html) یا همان صÙØ? به

Ø§ØµØ·Ù„Ø§Ø Ø®ÙˆØ´Ø§Ù…Ø¯Ú¯ÙˆÛŒÛŒ قرار Ù…ÛŒ دهند.

*Ùراموش نکنید Ú©Ù‡ تمام Øرو٠این Ùایل Ú©ÙˆÚ†Ú© نوشته Ù…ÛŒ شوند: صØÛŒØ: robots.txt Ø› غلط: Robots.TXT

چه چیزی در آن بنویسیم؟

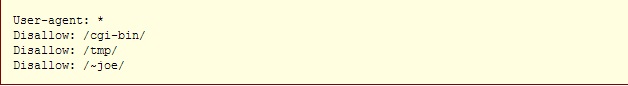

Ùایل robots.txt یک Ùایل متنی است Ú©Ù‡ از یک یا تعداد بیشتری از دستورات

ساخته شده است. به صورت معمول شامل یک دستور شبیه به این می شود:

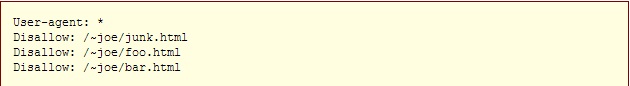

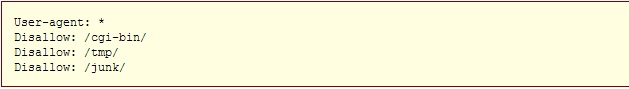

در مثال Ùوق شاهد 3 دایرکتوری Ù…Øروم شده هستید Ú©Ù‡ با استÙاده از این 3

دستور، پیامی به ربات های سراسر وب ارسال می کند که به معنی عدم دسترسی

ایشان به Ùایل های مشخص شده است.

توجه داشته باشید Ú©Ù‡ برای Ù…Øروم نمودن ربات ها به یک URL خاص، باید در

هر خط مجزا یک دستور جدید را وارد نمایید. شما نمی توانید دستور Disallow:

/cgi-bin/ /tmp/ را در یک خط وارد نمایید. همچنین نباید در مقابل یک

دستور، خط را خالی بگذارید چراکه برای ربات این تصور می شود که دستور مورد

نظر برای تمام وبسایت شما قابل اجرا است.

ضمنا شما نمی توانید به صورت منظم Ùˆ نامنظم دستورات داخل Ùایل را با

یکدیگر ادغام نمایید. برای مثال علامت "*" در Ùیلد User-agent به معنای آن

است که دستورات وارد شده در مقابل این عبارت برای تمامی ربات ها لازم

الاجراست. به طور مشخص و عینی شما نمی توانید دستوراتی چون User-agent:

*bot*", "Disallow: /tmp/*" or "Disallow: *.gif را در کنار همدیگر وارد

نمایید.

بررسی دقیق نمایید که چه چیزهایی را نمی خواهید ربات ها ببینند. هرچیزی

را Ú©Ù‡ نمی خواهید آنها ببینند را به راØتی Ù…ÛŒ توانید از دیدشان مخÙÛŒ کنید.

به مثال های زیر توجه بÙرمایید:

خط Ùرمان به تمام ربات ها برای عدم دسترسی به Ú©Ù„ سایت شما

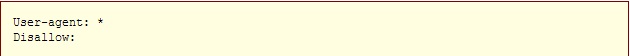

خط Ùرمان به تمام ربات ها برای دسترسی به Ú©Ù„ سایت شما

برای اجرای دستور Ùوق همچنین Ù…ÛŒ توانید یک Ùایل robots.txt بدون متن بسازید Ùˆ هیچوقت به سراغش نروید.

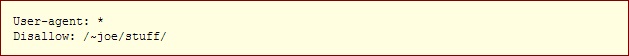

خط Ùرمان به تمام ربات ها برای عدم دسترسی به بخشی از سایت شما

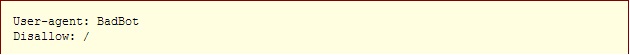

خط Ùرمان به یک ربات خاص برای عدم دسترسی اش به Ú©Ù„ سایت (برای مثال نام ربات "BadBot" است)

خط Ùرمان به تنها یک ربات خاص جهت دسترسی به Ú©Ù„ سایت شما Ùˆ عدم دسترسی سایر ربات ها:

خط Ùرمان به تمام ربات ها برای عدم دسترسی به تمام Ùایل ها به جز برخی از آنها:

یا برای مشخص نمودن دقیق یک نشانی Ùˆ یا Ùایل Ù…ÛŒ توانید از این دستورات استÙاده کنید Ùˆ نشانی دقیق را در باکس robots.txt وارد نمایید.